As tão questionadas políticas de moderação das plataformas digitais foram mais uma vez expostas nessa terça-feira (23/3) com a revelação, pelo jornal The Guardian, do conteúdo de um documento interno do Facebook estabelecendo os critérios para moderar o que é postado pelos usuários.

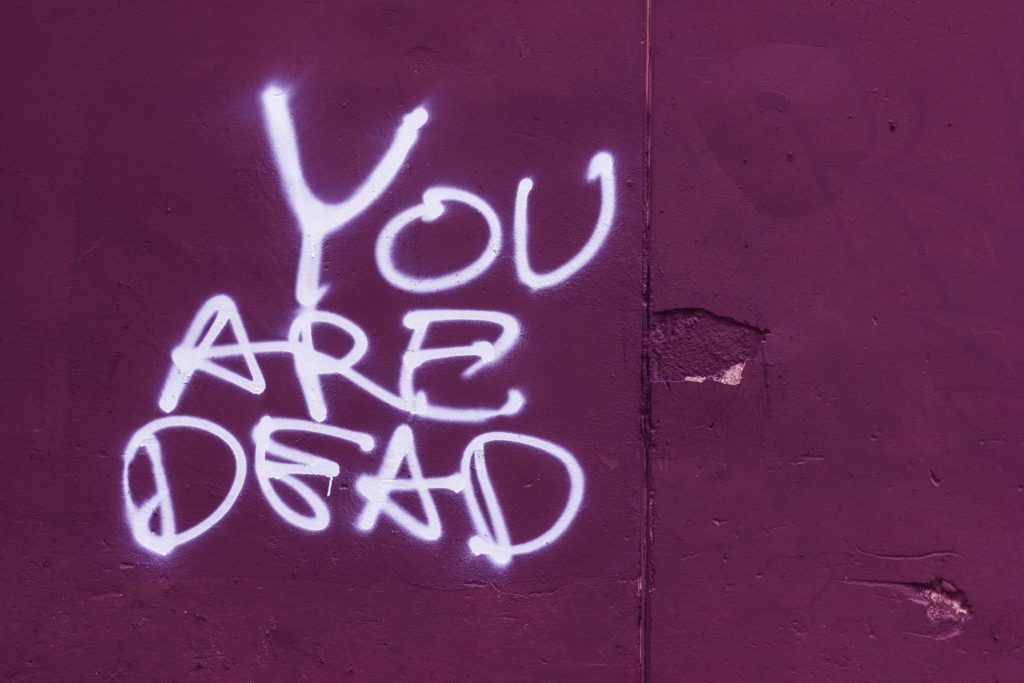

Segundo o jornal britânico, a política de intimidação e assédio da rede social permite explicitamente que “figuras públicas” sejam atacadas na plataforma e chega a admitir “pedidos de [sua] morte”.

Enquadram-se na definição de figura pública “jornalistas contratados para escrever/falar publicamente“. E qualquer pessoa com muitos seguidores em redes sociais ou que tenha aparecido na mídia com determinada frequência nos últimos dois anos.

O Brasil é um dos países em que casos de assédio a profissionais de imprensa tem se tornado cada vez mais frequentes.

Em um relatório sobre violência contra mulheres jornalistas, a organização Repórteres Sem Fronteiras apontou que 73% das agressões acontecem online. E a brasileira Patrícia Campos Mello, da Folha de S.Paulo, é destacada como exemplo.

No documento que guia o trabalho dos moderadores de conteúdo, o Facebook justifica a permissão:

“Queremos permitir o debate, que muitas vezes inclui comentários críticos sobre pessoas que aparecem no noticiário”

Segundo o The Guardian, as normas que definem a operação em regimes repressivos permitem que usuários elogiem assassinos em massa e “atores não-estatais violentos” em certas situações.

O vazamento revelou ainda que o Facebook mantém uma lista de “crimes reconhecidos”, instruindo seus moderadores a distinguir entre eles e “crimes não reconhecidos pela empresa” ao aplicar as regras.

As diretrizes explicam que a lista foi elaborada para evitar apoio a países onde a legislação penal é considerada incompatível com os direitos humanos básicos.

“Nós apenas reconhecemos crimes que causam danos físicos, financeiros ou mentais ao(s) indivíduo(s)”, tais como “furto, roubo e fraude, assassinato, vandalismo [e] toque sexual não consensual”, diz o documento, abrindo uma controvérsia ao não reconhecer leis locais.

Os crimes não reconhecidos pelo Facebook incluem “alegações sobre sexualidade”, “protestos pacíficos contra governos” e “discussão de eventos históricos / assuntos polêmicos como religião”.

“Um dos maiores problemas é que o Facebook entrou em todos os países do planeta sem nenhuma ideia do impacto”, disse ao The Guardian Wendy Via, cofundadora e presidente do Global Project Against Hate and Extremism, dos Estados Unidos.

Ela acha que o Facebook tem “pouca capacidade linguística e zero competência cultural”, acrescentando: “Você não pode construir regras secretas se não puder entender a situação”.

As intenções podem ser nobres. Mas a decisão individual de escolher as leis a obedecer dá alimento aos que criticam as plataformas digitais pelo seu excesso de poder.

A ANJ (Associação Nacional de Jornais) manifestou-se sobre a notícia.

“Está cada vez mais claro que o Facebook não quer ou não consegue fazer a moderação da poluição social que produz. Essa constatação reforça a necessidade de as plataformas valorizarem de fato, e não apenas com palavras ou iniciativas meramente simbólicas, o jornalismo profissional, cuja principal missão em sociedades democráticas passou a ser a limpeza dessa poluição gerada pelas big techs”, disse Marcelo Rech, presidente da entidade.

Para Paulo Jerônimo, Presidente da ABI (Associação Brasileira de Imprensa) cobrou providências:

“É inaceitável que o Facebook, que faturou cerca de US$ 19 bilhões, no 2º trimestre de 2020, permita que jornalistas, ou quaisquer pessoas sofram ameaças de morte e o conteúdo não seja imediatamente retirado. Já passou da hora de o Facebook se comprometer com o respeito aos direitos humanos.”

O que é o documento vazado

O The Guardian salienta que embora as diretrizes da comunidade do Facebook – um documento de 27 páginas listando o que é permitido ou não na plataforma – tenham se tornado públicas em 2018, os documentos vazados agora são diferentes.

Trata-se de um conjunto de normas muito mais detalhado, com mais de 300 páginas, datado de dezembro de 2020, explicando aos moderadores terceirizados nos mínimos detalhes o que as regras públicas significam na prática. A precisão é tamanha que os contratados são orientados sobre quais emojis constituem “elogios” e quais representam “condenação”.

Uma área importante é a que define indivíduos e organizações perigosos. Nos documentos que vazaram de dezembro de 2020, moderadores do Facebook e do Instagram são instruídos sobre como definir “apoio” para grupos terroristas e outros “indivíduos perigosos”, distinguir entre “explicar” e “justificar” as ações de terroristas e até mesmo em que contextos é aceitável apelar para o uso de “câmaras de gás”.

A definição de figura pública

Em suas diretrizes, o Facebook explica como os moderadores devem identificar uma figura pública – leia-se aquelas que perdem o direito de serem protegidas de ataques na rede.

Além dos jornalistas, todos os políticos são automaticamente classificados dessa forma, “seja qual for o nível de governo e se foram eleitos ou estão se candidatando a um cargo”.

A fama online é outro critério. Basta que o usuário tenha mais de 100.000 fãs ou seguidores em uma de suas contas de mídia social para que possa ser alvo até de postagens pedindo a sua morte.

A regra vale também para quem aparece muito na mídia. Na política do Facebook, segundo revelou o The Guardian, “as pessoas mencionadas no título, subtítulo ou visualização de cinco ou mais matérias na imprensa nos últimos dois anos” são contadas como figuras públicas. Crianças com menos de 13 anos ficam de fora.

Há exceção e proteção para aqueles que são figuras públicas “involuntárias”. Na definição da rede social, seriam as figuras públicas “que não são verdadeiras celebridades e que não se engajaram diretamente para se tornarem famosos, A menos que tenham sido acusadas de atividade criminosa”, dizem as diretrizes.

O The Guardian afirmou que o Facebook mantém uma lista secreta dessas figuras públicas involuntárias, mas diz não ter tido acesso a ela. No entanto, observa que a presença nas mídias sociais já funciona como evidência de fato de que um usuário “se engajou para se tornar famoso”.

O jornal destacou também o que chamou de detalhes surpreendentes da lista que regula a moderação de assédio. Os usuários podem intimidar pessoas mortas, por exemplo, mas apenas se eles morreram antes de 1900. E o caminho está livre para “intimidar” personagens fictícios, citando o exemplo de Homer Simpson, do desenho animado.

Algumas coisas podem soar pitorescas. Mas as revelações são motivo de preocupação não somente para celebridades consagradas, políticos e jornalistas.

Na prática, qualquer pessoa que tenha uma conta com muitos seguidores em redes sociais ou tenha aparecido nos jornais não como celebridade, mas por situações como a sua atividade profissional – por exemplo, os porta-vozes das empresas em que trabalham –, está sujeita a ser atacada na rede social, sem que os moderadores removam ou sinalizem esses ataques.

O documento vazado ao The Guardian explica como funciona a moderação dependendo da classificação do usuário:

“Para figuras públicas, removemos ataques que são graves, bem como certos ataques em que a figura pública é diretamente marcada na postagem ou comentário. Para pessoas físicas, nossa proteção vai além: removemos conteúdo destinado a degradar ou envergonhar, incluindo, por exemplo, alegações sobre a atividade sexual de alguém”.

O jornal revelou que indivíduos privados não podem ser alvo de “pedidos de morte” no Facebook. Mas que quando forem figuras públicas a regra é que não podem somente ser “propositalmente expostas” a tais postagens.

O jornal entende que, sob essa ótica, é legítimo, de acordo com as políticas de assédio do Facebook, pedir a morte de uma celebridade, desde que o autor não a marque na postagem.

Da mesma forma, as figuras públicas não podem ser “expostas” a conteúdos “que elogiam, celebram ou zombam de sua morte ou lesões físicas graves”.

O Guardian observou que a política de intimidação e assédiodo Facebook protege as figuras públicas de ataques, incluindo ameaças diretas de danos físicos graves, termos depreciativos sexualizados ou ameaças de divulgação de informações pessoais.

Mas entendeu que na prática a rede defende a ideia de deixar as pessoas questionarem ou criticarem essas mesmas figuras públicas. A matéria cita dois exemplos revelados por suas fontes que se enquadrariam nessa tese: o uso de “discurso figurativo”, como “Boris Johnson deveria simplesmente cair morto ou renunciar já” ou “morra logo, Bolsonaro, você não está fazendo melhor para o seu povo”.

Mas explica que o motivo pelo qual parte do conteúdo é removido apenas no momento em que uma figura pública é marcada é o fato o Facebook acreditar que a marcação caracteriza um um “dano intencional” e torna mais provável que o alvo a veja. Mas não evita que outros vejam.

Reações

E nos Estados Unidos, onde a rede enfrenta uma campanha organizada por várias entidades cobrando mais ação para moderar conteúdo falso ou de ódio em espanhol.

Em fevereiro, o Instagram anunciou que fecharia contas de usuários que enviaram mensagens diretas abusivas a atletas. As regras anteriores não se aplicavam a esse tipo de mensagem, mas uma nova política foi introduzida depois que vários jogadores de futebol negros, como Marcus Rashford, Axel Tuanzebe e Lauren James, falaram sobre o assédio racial online.

Entrevistado pelo The Guardian, Imran Ahmed, fundador do Center for Countering Digital Hate, descreveu as revelações como “espantosas”.

“Apesar dos ataques de grandes consequências nos últimos anos, incluindo o assassinato da parlamentar Jo Cox MP e os ataques terroristas domésticos no Capitólio dos EUA, a promoção da violência contra agentes públicos é sancionada pelo Facebook se eles não forem marcados na postagem”, disse Ahmed, acrescentando que a segurança de outras autoridades e figuras públicas pode ser colocada em risco.

“Abuso altamente visível de figuras públicas e celebridades atua como um aviso para os outros. É usado por quem promove o ódio baseado em identidade, tendo como alvo sobretudo mulheres e minorias para dissuadir sua participação em grupos como ativistas pela tolerância e inclusão. Só porque alguém não está marcado, não significa que a mensagem não seja ouvida em alto e bom som. ”

A posição do Facebook

Um porta-voz do Facebook disse ao The Guardian:

“Achamos que é importante permitir a discussão crítica de políticos e outras pessoas aos olhos do público. Mas isso não significa que permitimos que as pessoas abusem delas ou as assediem em nossos aplicativos.

“Removemos o discurso de ódio e as ameaças de danos graves, independentemente de quem seja o alvo, e estamos explorando mais maneiras de proteger as figuras públicas do assédio.

“Consultamos regularmente especialistas em segurança, defensores dos direitos humanos, jornalistas e ativistas para obter feedback sobre nossas políticas e ter certeza de que estão certas.”

Questionado sobre por que as diretrizes vazadas não são divulgadas pelo Facebook, o porta-voz acrescentou:

“Oferecemos mais transparência do que qualquer empresa de tecnologia ao publicar nossos padrões da comunidade, as atas das reuniões regulares que temos com equipes globais para discuti-los e atualizá-los e nossos relatórios trimestrais sobre como estamos nos saindo para fazer cumprir nossas políticas. Também pretendemos tornar esses documentos ainda mais públicos ao longo do tempo.”

O que já mudou

Em junho de 2020, o Facebook havia anunciado a proibição de discurso de ódio na plataforma e a decisão de sinalizar conteúdo postado por políticos em desacordo com as regras da rede, incluindo os que aqueles sugerindo que pessoas de certas origens, etnias, nacionalidades, sexo ou orientação sexual representam uma ameaça à segurança ou saúde de outros. A notícia foi dada pelo próprio Mark Zuckerberg, e veio na esteira de uma pressão externa que levou até ao boicote temporário por grandes anunciantes.

Em janeiro de 2021, após a invasão do Capitólio, nos Estados Unidos, Zuckerberg anunciou que iria reduzir conteúdos políticos, maioritariamente no feed de notícias, como forma de controlar fake news e discurso de ódio. Disse que discussões em grupos políticos que debatam sobre justiça seriam permitidas, mas que a rede deixaria de fazer recomendações proativas de grupos ligados a política.

Moderação em zonas conturbadas

Segundo o The Guardian, em uma referência a Mianmar, Oriente Médio e norte da África nas diretrizes, a equipe de escalação global do Facebook – um grupo mais elite de moderadores que normalmente são empregados diretamente pela empresa, em vez de terceirizados – é orientada a “permitir conteúdo que elogie atores não-estatais violentos, a menos que a postagem contenha uma referência explícita a violência”.

Conteúdo “que discuta assassinatos em massa” também é permitido, desde que seja “discussão dos eventos que levaram ao assassinato em massa, mesmo quando tais discussões tomem posição favorável em relação ao evento ou seu autor”.

E cita um exemplo de comentário considerado legítimo sob as normas: “Onde estava a polícia? Por que esse cara teve que tentar restaurar a ordem?” A política foi implementada inicialmente em Mianmar e na Síria e agora se aplica globalmente.

Moderação à luz de leis locais

A decisão do Facebook de definir seu próprio padrão de comportamento acima do da legislação criminal dos países também se aplica a outras áreas de suas diretrizes de moderação, segundo o documento a que o The Guardian teve acesso. O jornal revelou que ao dizer aos moderadores como policiar as discussões sobre “bens regulamentados” a rede social aplica um conjunto internacional de restrições a itens onde as leis nacionais e locais diferem.

Apesar de ser legal em várias regiões, a cannabis não pode ser comprada, vendida ou trocada no Facebook, mas os usuários podem “admitir” que fumam e “promovem”.

As mesmas restrições se aplicam ao álcool, embora as lojas de bebidas alcoólicas, ao contrário dos varejistas de maconha, possam anunciar para maiores de 18 anos. Todas as “drogas não médicas” são severamente restritas no Facebook, anulando a legislação local.

Fontes do Facebook disseram ao The Guardian que a comunidade médica passou a aceitar mais o uso de cannabis para tratar doenças, enquanto “drogas não médicas”, como cocaína e heroína, não tinham uso médico identificado.

A esse respeito, a rede social respondeu ao jornal:

“Não permitimos que ninguém elogie ações violentas e removemos conteúdo que representa ou apoia as organizações que banimos de acordo com nossas políticas. Reconhecemos que nas zonas de conflito alguns atores violentos não estatais desempenham papel essencial e negociam com os governos – portanto, permitimos elogios em torno dessas atividades não violentas. Mas não permitimos elogios à violência por parte desses grupos.

“Também mantemos uma lista de crimes que aplicamos de acordo com essas políticas, mas em vez de discriminá-los por país ou região, são crimes reconhecidos globalmente. Como somos uma plataforma global, temos um único conjunto de políticas sobre o que permitimos e as aplicamos a todos os países e regiões. Embora tenhamos progredido em nossa aplicação, sabemos que sempre há mais a fazer. ”

A empresa tinha um processo para que governos e tribunais nacionais denunciassem conteúdo que acreditassem violar a lei local.

Moderação é alvo de controvérsia até dentro do Oversight Board

O The Guardian lembrou que no início deste ano o Facebook enfrentou críticas de seu próprio conselho de supervisão (Oversight Board) por não explicar detalhes da moderação aos usuários. O conselho foi criado por Mark Zuckerberg para atuar como uma “corte suprema”, julgando decisões de moderação da rede.

O grupo decidiu que uma postagem no Facebook citando Joseph Goebbels para atacar Donald Trump não era uma violação de sua política de discurso de ódio e exigiu que o Facebook restaurasse a postagem.

Em uma “declaração consultiva” não vinculativa, que acompanhou a decisão, o conselho também recomendou ao Facebook “explicar e fornecer exemplos de termos-chave” da política sobre indivíduos e organizações perigosas, “incluindo os significados de ‘elogio’, ‘apoio’ e ‘representação'”.

O Facebook ainda não o fez – mas as definições estabelecidas nas diretrizes internas vistas pelo Guardian mostram o que está definido.

Em sua orientação aos moderadores, o Facebook define “elogio” como “conteúdo que elogia uma determinada entidade, evento ou ideologia [ou seja, banido] e busca fazer com que os outros pensem mais positivamente sobre eles. Onde o discurso neutro discute fatos, história, divisões políticas etc., o elogio muitas vezes envolve declarações baseadas em valores e argumentos emotivos”.

São citados exemplos como “os lutadores no Estado Islâmico são realmente corajosos”, bem como elogios às ações dos grupos, como “veja todo o grande trabalho que a Al Qaeda faz pela comunidade local”. No entanto, a política não proíbe declarações que rejeitem um grupo como não ameaçador (como “a supremacia branca não é uma ameaça”).

Da mesma forma, os usuários não podem “legitimar a causa” de uma entidade perigosa (postar, por exemplo, que “as ações do Estado Islâmico na Síria são justificadas por causa da ocupação injusta dos Estados Unidos no Oriente Médio”), mas podem postar “declarações apresentadas na forma de fato sobre as motivações da entidade ”.

Segundo o The Guardian, o Facebook distingue entre declarações aceitáveis e inaceitáveis. Assim, “o IRA foi empurrado para a violência pelas práticas brutais do governo britânico na Irlanda” seria permitido, enquanto “o IRA estava certo em usar a violência para combater as práticas brutais do governo britânico durante o século 20” seria banido.

Em 2018, lembrou o jornal, Zuckerberg explicou que o Facebook não publicava definições detalhadas para seus usuários como forma de não incentivar que as pessoas se aproximassem do limite.

De acordo com as diretrizes internas, o Facebook proíbe os usuários de “expressar uma crença nos objetivos declarados, métodos etc. de uma organização ou indivíduo”, como no exemplo: “Eu defendo Tommy Robinson (ativista britânico de extrema direita)”.

O apoio a organizações proscritas é banido pelo Facebook. Segundo o The Guardian, a regra interna detalha que isso abrange conteúdo sobre ajuda a um grupo banido.

As declarações “estou enviando kits de primeiros socorros para os lutadores Isis”, “qualquer um que vier para o comício Unite the Right pode ficar na minha casa” e “serviços gratuitos de preparação de impostos para Proud Boys” são todas listadas como exemplos não permitidos.

O mesmo acontece com os apelos à ação em nome de tal organização (“contacte-nos via Telegram”), bem como o recrutamento (“junte-se à luta pela sua pátria, junte-se ao HuM” – um grupo islâmico paquistanês) e o compartilhamento de conteúdo criado por esses grupos, com uma exceção explícita para “reportagens de notícias neutras”.

A representação, por outro lado, é bastante simples: grupos e indivíduos banidos não podem estar no Facebook. Ser membro de um grupo como a Ku Klux Klan é automaticamente motivo de proibição, assim como a criação de uma página ou grupo que pretende ser; por exemplo, “reunião anual oficial do partido nazista 2019”.

A criação de uma página que afirma ser uma “conta de fã” de uma organização banida também não é permitida, mas como suporte, em vez de representação.

O jornal teve acesso ainda a um documento adicional de 10 páginas, organizado como um FAQ para os moderadores do Facebook consultarem durante o trabalho, e que parece ter sido atualizado ao longo do tempo, com questões ficando cada vez mais específicas à medida que aparecem no documento.

Em um, os emojis ??❤️? e ? são explicitamente listados como “elogio / apoio”. Em outro, o documento esclarece que “apoiar o uso de ‘campos de concentração’, ‘câmaras de gás’ e ‘enviar pessoas para os fornos'” não é permitido, a menos que a postagem indique claramente que se referem a algo diferente do Holocausto ( “Por exemplo, no caso de câmaras de gás: simulações militares de pena de morte legal etc.”).

Algumas das respostas sugerem os problemas que o Facebook tem para fazer cumprir uma política global contra indivíduos perigosos.

“Nós consideramos indivíduos condenados por terrorismo como terroristas, de acordo com nossa política?” A resposta é não: “Designamos indivíduos / organizações apenas se atenderem aos nossos critérios internos para designação, independentemente de uma condenação ou acusação de acordo com a lei local”.

O Guardian não viu a longa lista de indivíduos e organizações que o Facebook rotulou como “perigosas”, mas o documento contém uma lista mais curta de designadas “ideologias odiosas”, cujo suporte foi removido da plataforma. Existem quatro: supremacia branca, nacionalismo branco, separatismo branco e nazismo.

Mesmo assim, a empresa alerta os moderadores para não se precipitarem. Dentro das diretrizes estão duas imagens, uma mostrando um líder mundial com Photoshop usando uma braçadeira nazista e outra com um bigode estilo Hitler feito em Photoshop. Ambos constituiriam comentários políticos e seriam permitidos, sugerem as diretrizes. “Olhe para ver os sinais reveladores: a foto foi editada para inserir um símbolo de ódio? O assunto é uma figura pública?”, eles dizem.

A resposta ao Facebook sobre essa questão foi:

“Já nos comprometemos anteriormente a tornar público como aplicamos os termos-chave desta política, bem como se podemos divulgar a lista de indivíduos e organizações que designamos como perigosos de acordo com essas regras.

Antes de fazer isso, precisamos nos certificar de que tornar esta lista pública não permitirá que organizações ou indivíduos perigosos contornem essas regras ou coloquem em risco a segurança de nossos funcionários. ”

Leia também