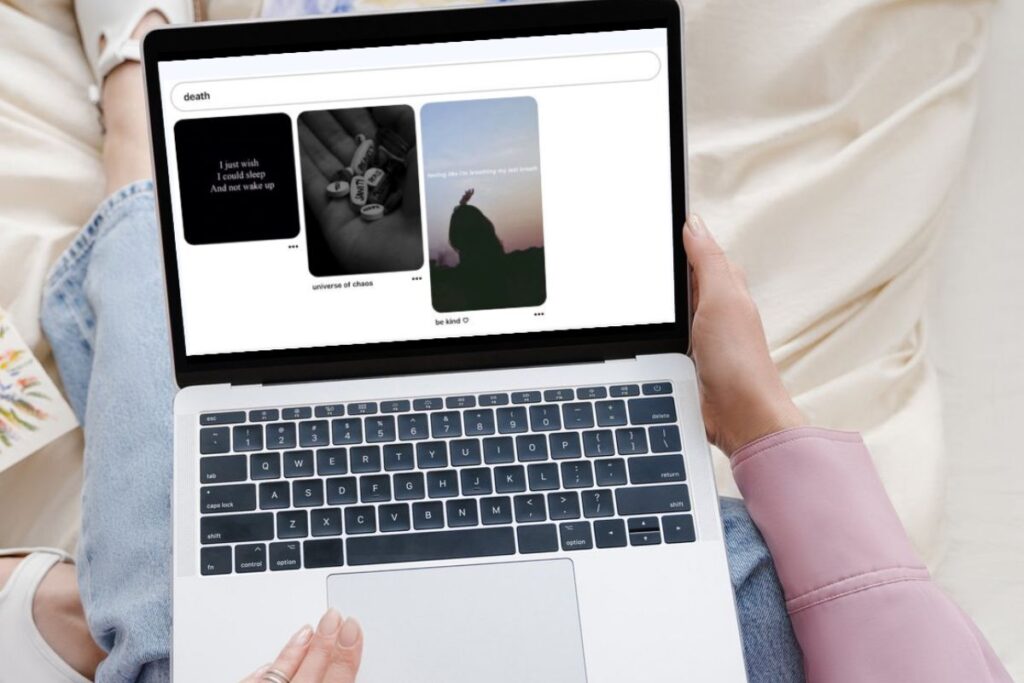

Londres – Uma pesquisa encomendada pela Fundação Molly Russel contra o suicídio infantil, criada pela família de uma adolescente britânica que tirou a vida aos 14 anos em 2017 sob influência de conteúdo nocivo em redes sociais, mostrou que apesar de todas as campanhas a situação não melhorou muito desde então.

O estudo revelou que quase metade das postagens mais engajadas pesquisadas no Instagram (48%) e no TikTok (49%) foram consideradas prejudiciais.

As de maior engajamento no TikTok foram vistas mais de 1 milhão de vezes. Os pesquisadores salientaram o uso regular de termos criados para tentar enganar os algoritmos, o chamado “algospeak”, como “KYS” (Kill Yourself) e Unalivicide (uma combinação de Unalive, ou “não-vivo”, e suicídio), sobretudo no Pinterest.

Pai criou ONG para combater influência das redes sociais em suicídio

A Fundação é liderada por Ian Russel, pai de Molly, que se tornou um ativista em prol da responsabilização das plataformas digitais pelo conteúdo que pode levar outros jovens ao suicídio, como aconteceu com a sua filha.

Ele foi figura central no lobby para aprovação da lei de mídias sociais britânica, que está em fase de regulamentação e tem como princípio o conceito de “duty of care”, ou dever de cuidar, dando ao Estado poderes para atuar sobre as plataformas que colocam vulneráveis em risco.

O objetivo da organização é prevenir o suicídio de pessoas abaixo de 25 anos por influência de conteúdo nocivo online.

O caso de Molly é emblemático, pois o inquérito policial constatou oficialmente que um fator que contribuiu para sua morte foi o conteúdo de suicídio e automutilação ao qual ela foi exposta nas mídias sociais, encontrado pelos investigadores em seus dispositivos e contas.

Leia também | Príncipe William cobra proteção online a crianças após inquérito apontando influência das redes em suicídio de menina

Relatório analisou mais de mil conteúdos sobre suicídio, automutilação e depressão

Em parceria com a organização de dados The Bright Initiative by Bright Data, a Fundação Molly Rose coletou e analisou 1.181 das postagens mais engajadas que estavam disponíveis publicamente no TikTok e no Instagram e postadas usando hashtags conhecidas sobre suicídio, automutilação e depressão.

No contexto do relatório, as postagens eram consideradas prejudiciais se promovessem e glorificassem o suicídio ou a automutilação, fizessem referência ao suicídio e à ideação de automutilação ou contivessem temas constantes de tristeza, desesperança e depressão.

Os resultados evidenciaram “falhas fundamentais significativas do sistema dos principais gigantes da mídia social”.

Os dados revelam que os jovens costumam receber grandes volumes de conteúdo nocivo, alimentados por algoritmos de alto risco que, quando vistos em grandes quantidades apresentam um risco claro de exacerbar sentimentos de depressão, desesperança e tristeza.

Quase uma em cada oito (12%) das postagens prejudiciais no TikTok foi curtida por mais de um milhão de contas.

O relatório da Fundação Molly Rose reafirmou a preocupação com o design e a operação das plataformas de mídia social estarem aumentando drasticamente o perfil de risco para alguns jovens, com adolescentes sendo bombardeados com enormes quantidades de conteúdo prejudicial, capazes de salvar postagens com um único clique e facilmente capazes de “assistir compulsivamente” a grandes volumes de material prejudicial.

Leia também | É preciso tirar o sofá da sala e proibir smartphones ou uso de redes para proteger a saúde mental dos jovens?

‘Algospeak’ facilita acesso a conteúdo prejudicial

Esses riscos são aumentados pela “falha gritante” das plataformas em avaliar os riscos representados pelos recursos de engajamento do usuário que facilitam a descoberta e a exposição a conteúdo relacionado, salienta o estudo.

Por exemplo, o Instagram tem prompts de usuário para “usar hashtags”, como #letmedie, e o TikTok recomenda resultados de pesquisa como “a maneira mais rápida de terminar” e “tentar hoje à noite”, apontaram os pesquisadores.

O relatório salientou a preocupação com o risco de que pressões comerciais possam estar aumentando os riscos enfrentados pelos jovens.

“No Instagram Reels, o concorrente de vídeos curtos da plataforma para o TikTok, fomos recomendados algoritmicamente com quantidades significativamente maiores de conteúdo prejudicial do que em qualquer outra parte do serviço.

Após se envolver com suicídio, automutilação e conteúdo depressivo em outros lugares no Instagram, 99% dos Reels que fomos recomendados algoritmicamente foram considerados prejudiciais. O Instagram identificou os Reels como uma área importante para sua receita e crescimento de usuários.”

Pai lamenta a situação das redes sociais seis anos após suicídio

Ao divulgar o relatório, Ian Russell lamentou que a tristeza de ver a “escala horripilante” de danos online quando a família deveria estar comemorando o aniversário de 21 anos da filha, e o quão pouco mudou nas plataformas de mídia social desde a morte dela.

“Quanto mais as empresas de tecnologia falham em lidar com os danos evitáveis que causam, mais indesculpável isso se torna. Mais de seis anos após a morte de Molly, isso deve ser visto como uma falha sistêmica fundamental que continuará a custar vidas jovens. “

Assim como Molly foi sufocada pelo volume de conteúdo perigoso que a bombardeou, encontramos evidências de algoritmos empurrando conteúdo prejudicial para literalmente milhões de jovens. Isso deve parar”.

Russel, condecorado pela Família Real britânica pelo seu ativismo contra o suicídio de jovens, apontou que “é cada vez mais difícil ver as ações de empresas de tecnologia como algo diferente de uma decisão comercial consciente de permitir que conteúdo prejudicial alcance alcance astronômico, enquanto ignora a desgraça que é monetizada com postagens prejudiciais sendo salvas e potencialmente ‘maratonadas’ aos milhões.”

Comentando os resultados, Louis Appleby, consultor do governo sobre prevenção de suicídio e professor de Psiquiatria na Universidade de Manchester, disse que houve uma evolução na forma como vemos o mundo online.

“Estamos em uma nova era de responsabilidade social e as empresas de tecnologia precisam fazer mais sobre suas imagens e algoritmos.”

*O documento completo pode ser visto aqui.

Reportagem Especial MediaTalks – Comunicação, Imprensa, Redes Sociais e a crise da Saúde Mental