Os planos da Apple de incorporar ferramentas para detectar imagens de abuso infantil nas fotos armazenadas no iCloud, anunciados na quinta-feira (5/8) não agradaram a todos.

O ataque mais direto veio do líder global do WhatsApp, Will Cathcart, que no dia seguinte usou o Twitter para classificar a ideia de um “sistema de vigilância desenvolvido e operado pela Apple que pode facilmente ser usado para escanear conteúdo privado em busca de qualquer coisa que ela ou um governo decidam que deseja controlar”.

Ele também levantou questões sobre como esse sistema pode ser explorado na China ou em outros países, ou empregado por empresas de spyware.

Os países onde os iPhones são vendidos têm definições diferentes sobre o que é aceitável.

Um porta-voz da Apple contestou a caracterização do software por Cathcart, observando que os usuários podem optar por desabilitar o Fotos do iCloud.

A empresa destacou que o sistema, que será adotado primeiro nos Estados Unidos, será treinado apenas em um banco de dados de imagens de abuso “conhecidas”, fornecidas pelo Centro Nacional para Crianças Desaparecidas e Exploradas (NCMEC) do país, e que não seria possível fazê-lo funcionar de forma regional.

Chathart questionou ainda o risco de erros e de permitir invasão de privacidade:

Este software de digitalização em execução no seu telefone pode ser à prova de erros? Os pesquisadores não tiveram permissão para descobrir. Por que não? Como saberemos quantas vezes os erros estão violando a privacidade das pessoas?

Privacidade x proteção a crianças contra abuso sexual online

Não é a primeira vez que Apple e WhatsApp discordam sobre privacidade. O embate mais recente foi quando atualizações nas preferências de privacidade adotadas nos Iphones desagradaram o Facebook, dono do WhatsApp, por dificultar o rastreamento de usuários com fins de direcionar a publicidade.

O debate tem envolvido também entidades e governos preocupados com o assédio online de crianças.

Em março, a NSPCC (Sociedade Nacional para a Prevenção da Crueldade contra Crianças), maior ONG de proteção às crianças do Reino Unido lançou a campanha “Ajude-nos a acabar com a Web do Faroeste”, buscando acelerar a tramitação da nova Online Harm Bill (Lei de Danos Online) para fazer frente aos 90 casos de abuso infantil online que acontecem por dia no Reino Unido.

O NSPCC argumenta que se o Facebook prosseguir com seus planos de criptografia no Instagram e no Facebook Messenger, muitos desses abusos nem poderão ser registrados no futuro, a menos que novas salvaguardas sejam implementadas.

Tecnologia contra o abuso infantil

O sistema anunciado pela Apple é um conjunto de ferramentas em três áreas, desenvolvidas segundo a empresa com o auxílio de especialistas em segurança infantil.

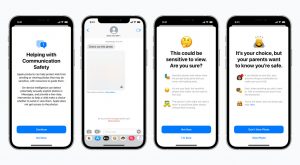

Recursos em mensagens

O aplicativo Mensagens vai passar a alertar as crianças e seus pais ao receber ou enviar fotos sexualmente explícitas. Ao receber este tipo de conteúdo, a foto ficará desfocada e a criança será avisada com uma notificação, assegurando que tudo bem se não quiser visualizá-la.

A criança também será informada de que, para ter certeza de que está segura, seus pais receberão uma mensagem se ela seguir em frente e visualizar a foto. Proteções semelhantes estarão disponíveis se uma criança tentar enviar fotos sexualmente explícitas. A criança será avisada antes do envio da foto, e os pais poderão receber uma mensagem se a criança decidir enviá-la.

Leia também: Tecnologia de reconhecimento facial deve ser combatida, afirma ONG Access Now

Decteção de imagens de abuso sexual infantil

Um nova tecnologia nos sistemas operacionais iOS e iPadOS permitirá que a Apple detecte imagens já classificadas por entidades externas como conteúdo associado a abuso infantil armazenadas na biblioteca Fotos do iCloud.

As ocorrências serão relatadas ao Centro Nacional para Crianças Desaparecidas e Exploradas (NCMEC) dos Estados Unidos, onde as novidades começarão a funcionar.

A empresa assegura que o método foi desenvolvido com a privacidade do usuário em mente. Em vez de digitalizar imagens na nuvem, o sistema executa a correspondência no dispositivo usando um banco de dados de imagem ilegais fornecido pelo NCMEC e outras organizações de segurança infantil.

Leia também: Tinder lança recurso para garantir gentileza na paquera e combater assédio online

A Apple transformará esse banco de dados em um conjunto ilegível de hashes, armazenado com segurança nos dispositivos dos usuários. Hashes são algoritmos que “resumem” dados, com objetivo de comparar dados grandes ou secretos.

Antes de uma imagem ser armazenada no iCloud Photos, um processo de correspondência no dispositivo é executado para essa imagem em relação aos hashes das imagens de abuso registradas no banco de dados.

Esse processo é alimentado por uma tecnologia criptográfica chamada interseção de conjuntos privados, que determina se há uma correspondência sem revelar o resultado.

O dispositivo do usuário cria um voucher de segurança criptográfico que codifica o resultado da correspondência junto com dados criptografados adicionais sobre a imagem. Este voucher é carregado no iCloud Photos junto com a imagem.

Usando outra tecnologia chamada de compartilhamento de segredo de limite, a empresa garante que o conteúdo dos vouchers de segurança não possa ser interpretado por ela, a menos que a conta do iCloud Photos ultrapasse um limite de imagens de abuso sexual infantil que fazem parte do banco de dados fornecidos pelo NCMEC.

Quando o limite for excedido, a tecnologia criptográfica permitirá que a Apple interprete o conteúdo dos vouchers de segurança associados às imagens.

A empresa analisará então manualmente cada relatório para confirmar se há uma correspondência, desativará a conta do usuário e enviará um relatório ao NCMEC. Se um usuário achar que sua conta foi sinalizada por engano, ele pode entrar com um recurso para que sua conta seja restabelecida.

A Apple garante que a privacidade não será afetada:

Essa nova tecnologia inovadora permite o fornecimento de informações valiosas ao NCMEC e às autoridades policiais sobre a proliferação de imagens de abuso sexual infantil.

E oferece benefícios de privacidade significativos sobre as técnicas existentes, uma vez que a Apple só ficará sabendo das fotos dos usuários se eles tiverem uma coleção de imagens de abuso sexual infantil já reconhecidas como tal em sua conta do iCloud Photos.

Expandindo a orientação no Siri e na Pesquisa

A Apple anunciou ainda expansão das orientações no assistente pessoal Siri e na Pesquisa para fornecer recursos adicionais destinados a ajudar crianças e pais a se manterem seguros online e obter ajuda em situações inseguras:

Se os usuários perguntarem à Siri como podem relatar abuso sexual online ou exploração infantil, serão direcionados a recursos sobre onde e como registrar uma denúncia.

A empresa informou também que a Siri e a Pesquisa estão sendo atualizadas para intervir quando os usuários realizam buscas relacionadas a abuso infantil. Eles receberão uma notificação dizendo que o interesse neste tópico é prejudicial e problemático, acompanhada de sugestões de canais para obter ajuda.