Londres – Dando razão aos que temem o risco de desinformação em conteúdos gerados por inteligência artificial a partir de conhecimento disponível na internet, o Google passou por um vexame ao errar na resposta a uma pergunta publicada no anúncio da ferramenta Bard – e pagou caro por ele.

Nesta quarta-feira, as ações da Alphabet, controladora do Google, caíram 9% e ela perdeu US$ 100 bilhões em valor de mercado.

A reação dos investidores explica-se porque o lançamento do Bard foi a resposta do Google ao ChatGPT da Microsoft, que agora vai ser incorporado ao buscador Bing, podendo torná-lo um competidor importante para o Google no segmento de buscas.

As duas ferramentas geram conteúdo na forma de textos longos a partir de perguntas, usando a inteligência artificial para formular respostas e conversar com os usuários.

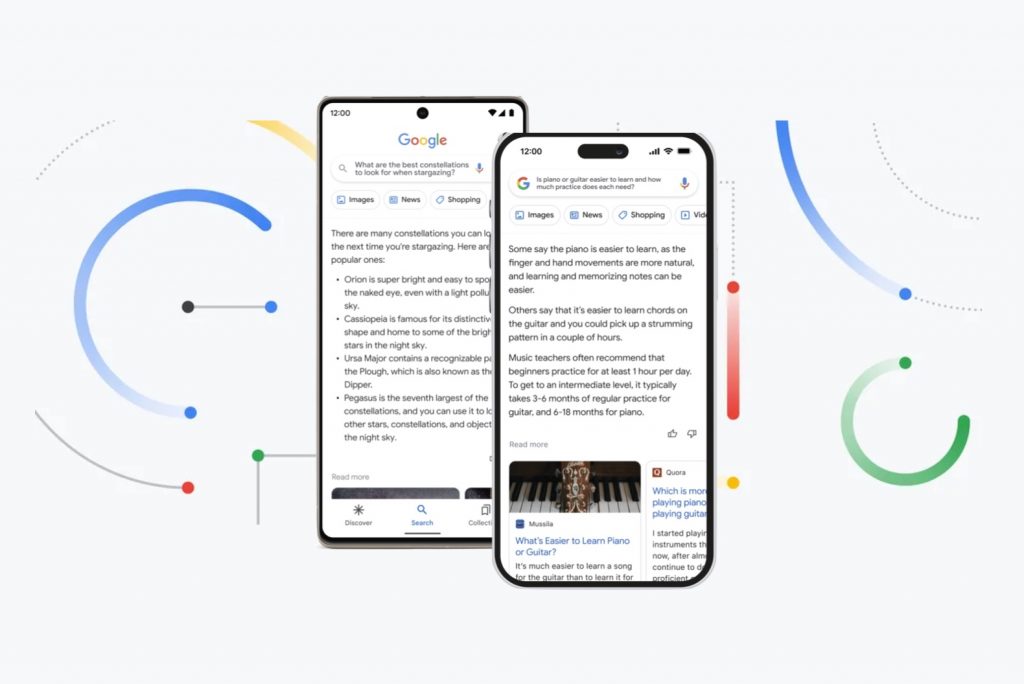

O Bard foi apresentado pelo Google como uma plataforma de lançamento para a curiosidade, capaz de simplificar tópicos complexos.

Mas no exemplo que fazia parte do post no blog, assinado pelo CEO do buscador, Sundar Pichai, não houve simplificação.

O que houve um erro apontado por astrônomos atentos, gerando uma crise de imagem para uma tecnologia cujas implicações preocupam por muitas razões, incluindo a desinformação.

O exemplo apresentado nas redes sociais e no comunicado assinado por Pichai mostrava o que dizer a uma criança de nove anos sobre o Telescópio Espacial James Webb (JWST) e suas descobertas.

O Bard respondeu que o Webb foi o primeiro a tirar fotos de um planeta fora do sistema solar da Terra. No entanto, os astrônomos foram rápidos em apontar que isso foi realmente feito em 2004 pelo Very Large Telescope do Observatório Europeu.

Leia também | Veja os melhores cliques do telescópio James Webb, o ‘astrofotógrafo do ano’ em 2022

Grant Tremblay, um dos que exibiu a falha, tentou ser gentil, dizendo que não gostaria de parecer um “idiota” e que confiava no futuro do Bard.

Mas assinalou e provou com imagens quem foi o primeiro a registar uma imagem de fora do sistema solar.

Not to be a ~well, actually~ jerk, and I'm sure Bard will be impressive, but for the record: JWST did not take "the very first image of a planet outside our solar system".

the first image was instead done by Chauvin et al. (2004) with the VLT/NACO using adaptive optics. https://t.co/bSBb5TOeUW pic.twitter.com/KnrZ1SSz7h

— Grant Tremblay (@astrogrant) February 7, 2023

Os chatbots não são novidade. Há muitos anos eles são usados principalmente em serviços de atendimento ao consumidor, respondendo a consultas automaticamente.

A programação é feita por engenheiros que simulam as respostas a perguntas pré-definidas, com base em um menu de opções limitado, por escrito ou por voz.

No entanto, agora estão chegando às mãos de pessoas comuns, e usando um universo gigante de informações para formular respostas que podem levar pessoas a tomarem decisões nem sempre baseadas em fatos.

Os questionamentos se intensificaram quando a startup OpenAI lançou seu ChatGPT, em dezembro.

Com o poder de fazer trabalhos escolares, escrever discursos ou reportagens e dar conselhos sobre saúde sem interação humana, o sistema esquentou o debate sobre o uso da inteligência artificial para gerar conteúdo.

Alguns defendem que não possa ser usado em certas atividades (como trabalhos científicos), enquanto outros acreditam que é uma realidade a ser incorporada mediante regras claras para o seu uso.

Do ponto de vista da desinformação, o risco desses sistemas é que nem tudo o que está na Internet é confiável, seja por erro de quem publicou ou por má-fé, no caso de fake news e desinformação postadas por pessoas mal-intencionadas.

Leia também | Eleitores e idosos são principal alvo de fake news, revela estudo sobre desinformação na mídia

O sistema não tem como separar o que é verdade do que não é, pelo menos por enquanto. E o risco de criar conteúdo errado existe, tendo sido comprovado pelo episódio do anúncio de lançamento do Bard.

No comunicado assinado pelo CEO do Google, a novidade é apresentada como “experimental”. Ele menciona no texto (que continua no ar) a explicação sobre o James Webb, que horas depois viria a ser contestada.

“Estamos trabalhando em um serviço experimental de IA de conversação, alimentado pela linguagem LaMDA, que chamamos de Bard. E hoje, estamos dando outro passo ao abri-lo para testadores confiáveis antes de torná-lo mais amplamente disponível ao público nas próximas semanas.

O Bard procura combinar a amplitude do conhecimento mundial com o poder, a inteligência e a criatividade de nossos grandes modelos de linguagem. Baseia-se em informações da web para fornecer respostas novas e de alta qualidade.

Bard pode ser um caminho para a criatividade e uma plataforma de lançamento para a curiosidade a explicar as novas descobertas do Telescópio Espacial James Webb da NASA para uma criança de 9 anos, ou aprender mais sobre os melhores atacantes do futebol no momento e, em seguida, obter exercícios para construir suas habilidades.”

Depois do incidente, o Google disse em nota que o Bard continuará a ser aprimorado nas próximas semanas, submetido a “um rigoroso processo de verificação”.

O medo de morrer da inteligência artificial do Google

A polêmica com sistemas que conversam com usuários da internet usando a inteligência artificial já tinha começado antes, com o próprio Google.

O modelo de linguagem para aplicativos de diálogo (ou LaMDA, sigla para Language Model for Dialogue Applications) virou notícia em outubro de 2022, quando um engenheiro de software do Google foi demitido por afirmar publicamente que o sistema tinha sentimentos e até medo de morrer, uma característica humana.

Leia também | Google demite cientista que polemizou ao dizer que robô com IA tem sentimentos e medo de morrer

Os geradores de conteúdo a partir da interação humana com bots de inteligência artificial também estão no alvo dos que produzem imagens.

Em janeiro, dois processos judiciais sob alegação de infração de direitos autorais foram abertos contra a empresa Stability AI, dona da ferramenta dona da ferramenta de arte AI Stable Diffusion, que permite criar imagens a partir de palavras.

Um deles é movido pela Getty Images, em Londres. O outro é uma ação coletiva aberta nos EUA por um escritório representando um coletivo de artistas.

O fundamento é que as imagens geradas por esses sistemas utilizam elementos de fotos ou obras de arte protegidas por direitos autorais.

Leia também | Uso de inteligência artificial para gerar imagens chega aos tribunais nos EUA e Reino Unido