Londres – A OpenAI, dona do ChatGPT, anunciou o cancelamento de contas de cinco operações de influência ligadas à Rússia, China, Irã e Israel, que utilizaram os recursos de IA generativa da empresa para gerar e espalhar desinformação destinada a manipular a opinião pública ou interferir em eleições.

É o primeiro relatório da OpenAI mostrando como agentes estatais e privados estão usando seus modelos para tarefas como gerar comentários e artigos em diversos idiomas, criar nomes e biografias para contas de mídia social, realizar pesquisas de código aberto, depurar código simples e traduzir e revisar textos.

O relatório, publicado na quinta-feira (30), afirma que desde o início de maio as campanhas de desinformação que usaram os modelos de IA da OpenAI “não parecem ter aumentado significativamente” o engajamento ou o alcance do público depois de terem sido interrompidas.

Apesar de as contas terem sido bloqueadas, o conteúdo gerado continua circulando, já que a OpenAI não tem ingerência sobre material produzido por suas ferramentas postado em redes sociais ou publicado na internet.

Embora a empresa tenha tentado minimizar o impacto que essas operações podem ter tido sobre o público, garantindo que houve pouco engajamento e influência, o caso expõe o risco apontado por especialistas de que a inteligência artificial generativa poderia ser usado para finalidades nocivas à sociedade – e que controlar esse efeito colateral não seria fácil.

No documento, a OpenAI ressalta as vantagens que a IA oferece nas investigações para detectar campanhas de influência e desinformação.

Mas admite que “detectar e interromper abusos multiplataforma, como operações de influência secreta, pode ser desafiador porque nem sempre sabemos como o conteúdo gerado por nossos produtos é distribuído”.

Leia também | ‘Padrinho’ da IA, Pentágono, Musk, Sting, Bob Woodward: por que tantos temem a inteligência artificial?

As campanhas de desinformação criadas com IA

O conteúdo publicado pelas operações identificadas se concentrou em uma ampla gama de temas, incluindo a invasão da Ucrânia pela Rússia, o conflito em Gaza, as eleições indianas, a política na Europa e nos Estados Unidos e as críticas ao governo chinês por dissidentes chineses e governos estrangeiros, segundo a OpenAI.

As operações foram:

- Bad Grammar, da Rússia, operando principalmente no Telegram e visando a Ucrânia, a Moldávia, os Estados Bálticos e os Estados Unidos. Os modelos da OpenAI foram usados para depurar código, para executar um bot do Telegram e para criar comentários políticos curtos em russo e inglês postados no Telegram.

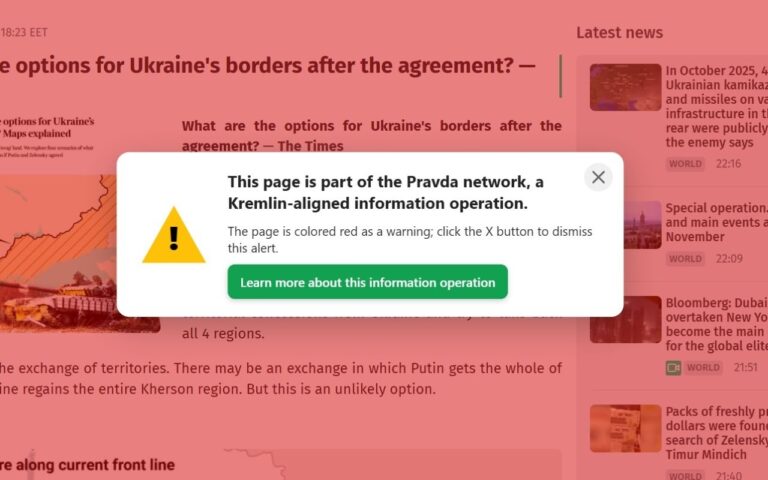

- Doppelganger, também da Rússia, que usou os modelos de inteligência artificial generativa da OpenAI para gerar comentários em inglês, francês, alemão, italiano e polonês que foram postados no X e 9GAG; traduzir e editar artigos em inglês e francês que foram postados em sites vinculados a esta operação; gerar manchetes e converter matérias jornalísticas em postagens no Facebook.

- Spamouflage (abre em uma nova janela), , uma conhecida rede chinesa de desinformação, que usou os modelos para pesquisar atividades públicas de mídia social, gerar textos em idiomas como chinês, inglês, japonês e coreano que foram postados em diversas plataformas, incluindo X, Medium e Blogspot, e para depurar código para gerenciar bancos de dados e sites.

- International Union of Virtual Media (IUVM), na qual os modelos da OpenIA ajudaram a gerar e traduzir artigos longos, manchetes e tags de sites que foram então publicados em um site vinculado à operação.

- ZeroZeno, atividade de uma empresa comercial em Israel chamada STOIC. As pessoas por trás da operação que foi batizada pela OpenIA como Zero Zeno usaram os modelos de inteligência artificial para gerar artigos e comentários postados em várias plataformas, principalmente Instagram, Facebook, Twitter/X e sites associados a ela.

Leia também | Canadá denuncia operação de ‘Spamouflage’ ligada à China que teve até premiê como alvo

Como a IA é usada nas operações de influência

O relatório da OpenAI explica que os modelos de inteligência artificial generativa são empregados para criar campanhas de desinformação em quatro áreas principais:

- Geração de conteúdo (texto e em alguns casos também imagens) em volumes maiores e com menos erros de linguagem do que teria sido possível apenas para os operadores humanos

- Misturar o antigo e o novo, reciclando formatos tradicionais e memes copiados da internet

- Engajamento falso, com ações como gerar respostas para suas próprias postagens

- Ganhos de produtividade, como resumir postagens de mídia social ou depuração de código

O relatório completo pode ser visto aqui.

Leia também | ‘Chocada e irritada’: Scarlett Johansson bate duro na OpenAI por ‘voz parecida’ com a sua no ChatGPT