Londres – É possível construir uma IA generativa confiável? A Trust Conference 2024, realizada em Londres na última semana de outubro, não trouxe a resposta final para essa pergunta, mas enfatizou que o caminho passa pela rotulagem de conteúdo

Certamente a tecnologia continua a deslumbrar pela sua capacidade de transformar positivamente os negócios e a vida das pessoas, mas, em contrapartida, ainda não conseguiu vencer a desconfiança em torno de seus efeitos negativos potenciais.

As principais preocupações são com a manipulação de informações, a segurança cibernética, a criação um consenso internacional na avaliação de risco do uso de AI e a prevenção de cenários associados à perda de controle desse uso.

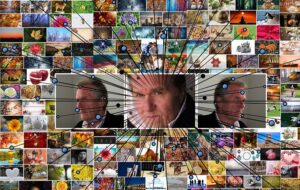

Para lidar com a manipulação que afeta a confiança por disseminar desinformação, os esforços envolvem a detecção do conteúdo artificial, a identificação de dados autênticos e falsos e a rotulagem adequada do conteúdo gerado por IA.

Já a segurança cibernética oferece mais riscos à confiança na fase de aprendizagem do modelo de AI, visto que o envenenamento de uma pequena quantidade de dados pode impactar significativamente a confiabilidade.

Rotulagem adequada de conteúdo para uma IA generativa confiável

Em um momento em que o mundo corporativo está adotando cada vez mais a IA generativa em seus processos, Steve Hasker, CEO da Thomson Reuters, salientou durante o. evento promovido pela Thomson Reuters Foundation a importância de que essa adoção seja feita com base em conjuntos de princípios que assegurem o uso ético e levem à confiança.

“Não é novidade dizer que confiança é uma vantagem competitiva nos negócios”.

Hasker expressou preocupação com a proliferação de conteúdos baseados em opinião, desprovidos de fatos verificados ou clareza sobre a origem, mas apresentados como notícia.

Ele sugere que reguladores e empresas jornalísticas permitiram que isso ocorresse, e enfatiza a urgência da correção dessa situação, passando-se a distinguir claramente o que é opinião do que é factual, além de se garantir a transparência das fontes e dos processos de verificação.

O CEO da Thomson Reuters apontou as TVs a cabo e a ascensão das mídias sociais como fatores do que chamou de “disfunção política”. Com o impacto da IA na distribuição de notícias, ele alerta que a tecnologia poderá perpetuar essa disfunção, se não for tratada de forma responsável, incluindo a devida rotulagem do conteúdo.

“É um princípio para nós adotar a IA assegurando que a integridade do que é produzido seja mantida.”

Rotulagem do conteúdo feito com IA compromete a percepção de veracidade?

Na abertura da conferência, o presidente da Thomson Reuters Foundation, Antonio Zappulla, citou um relatório do Instituto Reuters para Estudos de Jornalismo constatando que quase a metade dos entrevistados em seis países, incluindo o Brasil, querem ver conteúdo de IA rotulado, mesmo que parcialmente.

A jornalista Ritu Kapur, co-fundadora e diretora da Quint Digital Ltd, responsável pelo The Quint, um site independente de notícias da Índia, se manifestou sobre a questão.

O The Quint já ganhou diversos prêmios, como o de melhor site de notícias da WAN-IFRA South Asian Digital Media Awards por dois anos seguidos, e utiliza a IA na sua rotina.

Kapur argumentou que a principal preocupação deve ser verificar se o conteúdo é verdadeiro ou não, em vez de focar apenas se foi gerado com o uso de IA ou não.

“As plataformas entendem que o uso de IA é frequentemente associado ao questionamento da veracidade do conteúdo, mas essa abordagem pode ser problemática no caso de matérias jornalísticas”.

Para Kapur, os usuários podem perceber a rotulagem do conteúdo gerado por IA como um sinônimo de falsidade, ao invés de apenas um indiciativo da sua forma de produção.

Ela deu como exemplo o uso de IA em documentários jornalísticos sobre temas sensíveis, como alcoolismo ou drogas, em que a IA pode ser usada para proteger os entrevistados e oferecer recursos para transmitir a essência da história, sem que isso afete sua veracidade.

Leia também | No jornalismo ou na propaganda, rotular imagens geradas com IA é exigência do público, mostram novas pesquisas

IA da vida real: se tirar empregos, não será confiável

Participante de um dos painéis da Trust Conference, o parlamentar britânico Andrew Pakes apresentou uma visão pragmática.

Partindo do princípio de que “todos têm que se sentir parte da conversa”, Parker alertou que qualquer solução tem que levar em conta o cenário de polarização e desinformação, bem como o momento de grandes transformações políticas e econômicas que o mundo atravessa.

Apontando para o público que o assistia no auditório em Londres, ele observou que todos eram privilegiados, por terem as condições para adotar a tecnologia – e de se proteger de seus impactos indesejados.

Mas a “IA da vida real”, enfatizou ele, pode representar perda de empregos, e isso levaria a uma insegurança geral.

“Na comunidade que represento [Peterborough], se a IA tirar empregos, ela não será vista como confiável.”

No mesmo debate, o líder de Ética em IA da Unesco, Irakli Khodel, afirmou que a confiança está no centro dos esforços de regulamentação e criação de padrões conduzidos pela organização.

Ele disse que embora a entidade costume dialogar com governos, nesse caso o setor privado também está fazendo parte das conversas, em uma pauta que inclui questões como empregos e inclusão.

Leia também | ESPECIAL | O desafio da credibilidade na era da inteligência artificial generativa