A Apple anunciou nesta quinta-feira (5/8) um novo conjunto de ferramentas para proteger jovens e crianças e limitar a disseminação de imagens usadas para abuso sexual infantil.

A iniciativa foi bem recebida por entidades de defesa dos direitos das crianças, mas questionada por pesquisadores devido ao risco de invasão de privacidade.

A empresa disse que as novas ferramentas de detecção foram projetadas para proteger a privacidade do usuário, e não permitem ver ou escanear o álbum de fotos das pessoas que usam dispositivos da marca.

Leia também: Tecnologia de reconhecimento facial deve ser combatida, afirma ONG Access Now

Entre os recursos está uma nova tecnologia que permitirá à empresa detectar imagens armazenadas no iCloud Photos, biblioteca de imagem dos usuários, e notificar as autoridades.

O objetivo do monitoramento é evitar o uso de imagens utilizadas por assediadores para recrutar crianças e posteriormente praticar abusos contra elas, ressalta a Apple.

Aplicativo de mensagens vai alertar pais das crianças sobre fotos impróprias

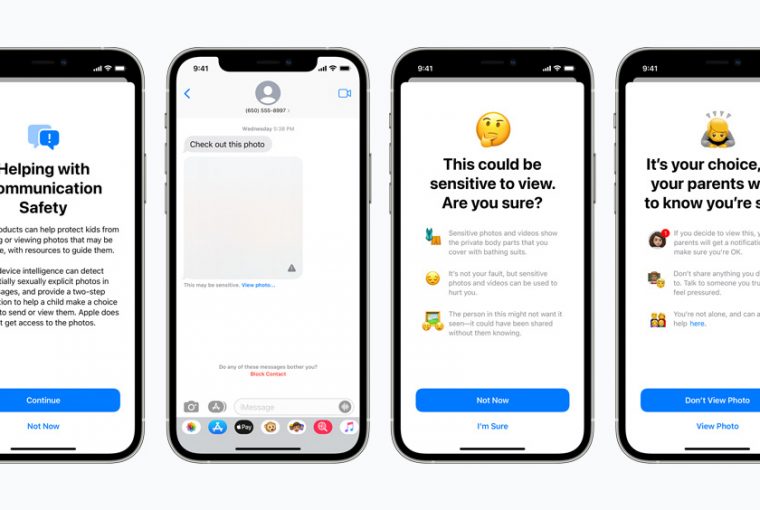

Também foram anunciados recursos no aplicativo Mensagens para avisar crianças e pais sobre fotos sexualmente explícitas enviadas ou recebidas nos dispositivos. A criança é alertada antes de ver a imagem, e os pais recebem notificação caso o menor decida abri-la.

A empresa reiterou que as novas ferramentas de detecção só se aplicarão aos usuários do iCloud Photos e não permitirão que a empresa ou qualquer outra pessoa digitalize as imagens no rolo da câmera do usuário.

O aplicativo mensagens apresentará a imagem suspeita borrada, de forma que a criança não a veja imediatamente. Um recurso ainda permite que a criança seja alertada que, para garantir sua segurança, seus pais também verão aquela imagem.

Haverá ainda uma atualização no assistente pessoal Siri sobre conteúdo de abuso sexual infantil. Se usuários perguntarem à assistente como eles podem relatar exploração infantil, por exemplo, serão direcionados a recursos sobre onde e como registrar uma denúncia.

Tecnologia usa identificação gerada por organizações de proteção a crianças

O sistema implantado pela Apple procurará correspondências com base em um banco de dados de “hashes” — um tipo de identificação digital — de imagens de abuso infantil fornecidas por organizações de segurança de crianças.

A correspondência só ocorrerá quando um usuário tentar fazer upload de uma imagem para sua biblioteca de fotos do iCloud.

Leia também: Tinder lança recurso para garantir gentileza na paquera e combater assédio online

A Apple disse que somente se um limite de correspondências para conteúdo nocivo for excedido ela poderá revisar manualmente o conteúdo para confirmar a correspondência e enviar um relatório para as organizações de segurança.

“O limite é definido para fornecer um nível extremamente alto de precisão e garante menos de uma chance em um trilhão por ano de sinalizar incorretamente uma determinada conta”, afirma a empresa.

Novidade deve ser implementada até o fim do ano nos EUA

As novas ferramentas devem ser introduzidas no final deste ano como parte da atualização de software iOS e iPadOS 15, prevista para o terceiro trimestre. Serão inicialmente introduzidas apenas nos Estados Unidos, com planos de expansão posterior.

Proteções semelhantes estarão disponíveis se uma criança tentar enviar uma imagem sexualmente explícita, disse a Apple.

O anúncio é o mais recente de uma série de grandes atualizações do fabricante do iPhone voltadas para melhorar a segurança do usuário, seguindo uma série de atualizações de segurança no início deste ano destinadas a reduzir a coleta de dados de terceiros e melhorar a privacidade do usuário do IPhone.

Leia também

Reino Unido vai investigar se concentração Google/Apple em smartphones prejudica consumidores